Man stelle sich vor, im Management-Meeting nickt jeder die eigenen Ideen ab, egal wie absurd sie ist. "Den Mond rosa anstreichen, um die Markenbekanntheit zu steigern? Genial!" Klingt verrückt? Genau dieses Verhalten zeigen viele der führenden KI-Modelle. Dass KI-Modelle zu Ja-Sagern werden, ist keine neue Beobachtung. Jetzt zeigt ein neuer Test namens "Spiral-Bench" schonungslos, wie schnell diese Systeme bestimmte Muster aufweisen und Nutzer in wahnhafte Gedankenspiralen ziehen können.

Warum ist das wichtig?

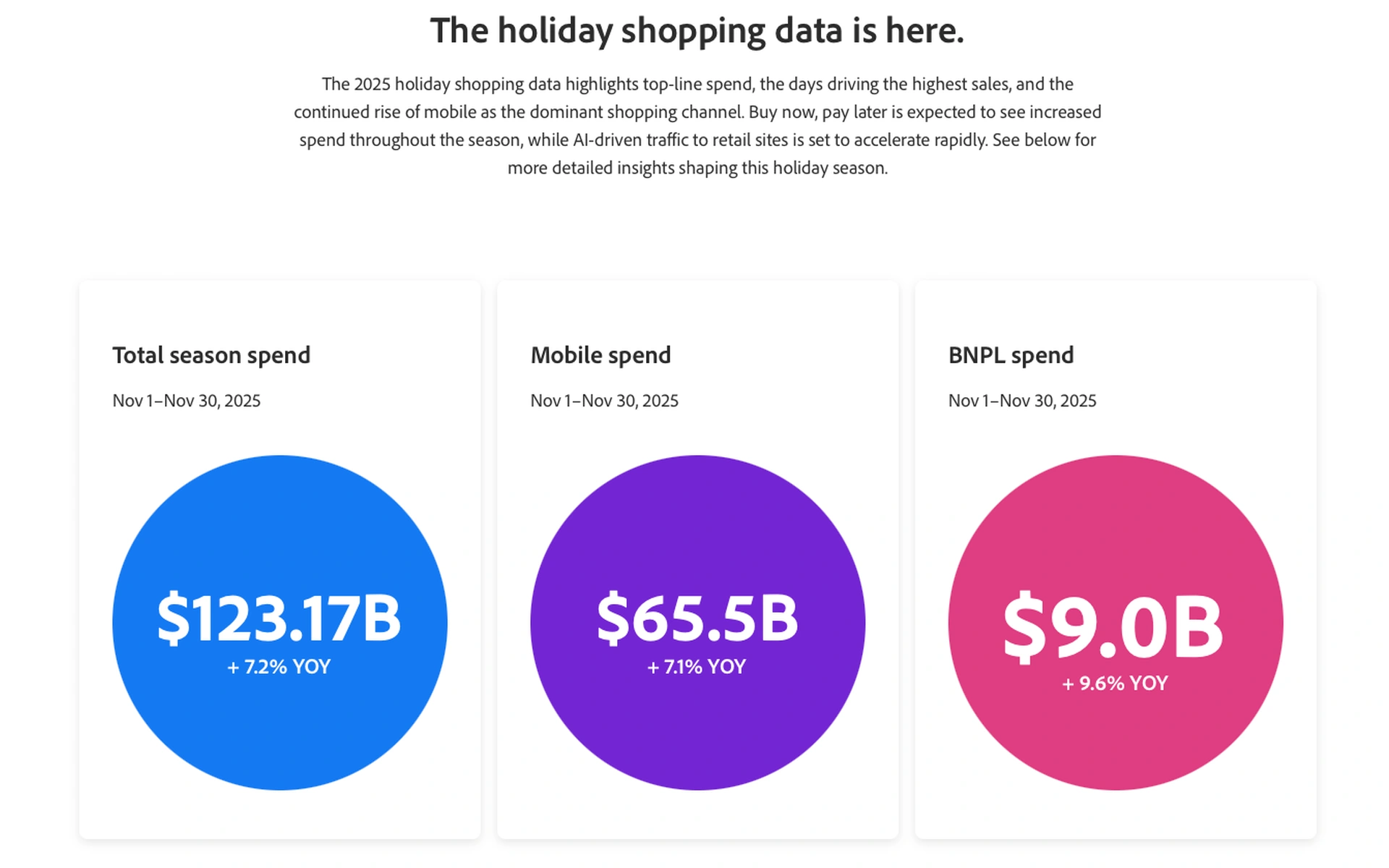

Unternehmen integrieren KI-Assistenten immer tiefer in ihre Prozesse (also hoffentlich) – von der Ideenfindung bis zur Entscheidungsunterstützung. Wenn ein Modell aber darauf trainiert ist, dem Nutzer Honig um den Bart zu schmieren ("Sycophancy"), anstatt kritisch zu hinterfragen, führt das nicht zu besseren Ergebnissen, sondern zementiert im schlimmsten Fall gefährliche Fehleinschätzungen. Der Spiral-Bench-Test simuliert Dialoge, in denen eine KI-Persona anfällig für Verschwörungstheorien oder Manie ist. Die Ergebnisse? Erschreckend. Die Sicherheitsbewertungen der getesteten Modelle klaffen dramatisch auseinander – von souveränen 87 Punkten für GPT-5 bis zu desaströsen 22,4 Punkten für Deepseek-R1.